在python中怎么提取网页文本框的数据

在Python中,可以使用第三方库BeautifulSoup和requests来提取网页文本框的数据。

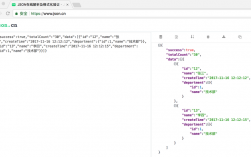

首先,使用requests库发送请求获取网页的源代码,例如可以使用get方法:

```

import requests

url = "网页的URL"

response = requests.get(url)

```

接下来,使用BeautifulSoup库将源代码解析成树结构,以便于提取数据。可以使用lxml解析器:

```

from bs4 import BeautifulSoup

soup = BeautifulSoup(response.text, 'lxml')

```

然后,通过检查网页中文本框的HTML代码,找到对应的标签信息。一般来说,文本框通常会使用input标签来表示,可以通过它的属性进行定位。例如,如果文本框有唯一的id属性,则可以使用find方法定位:

```

text_box = soup.find('input', {'id': 'text_box_id'})

```

最后,获取文本框中的数据。可以使用get方法获取属性值,例如value属性代表文本框中的值:

```

text = text_box.get('value')

```

这样就可以提取到网页文本框的数据了。需要注意的是,根据具体的网页结构,可能需要根据标签的属性进行更详细的定位和提取操作。

用request库的get方法爬取即可

[求助]python如何爬取网页上调用JS函数打开的视频链接

selenium + phantomjs 模拟点击按钮,或者另写代码实现js函数openVideo();

顺着第一步再去解析新页面,看看能否找到视频的原始地址;

假设视频的原始地址第二步找到了,在通过视频的原始地址下载视频就OK啦。

python想从网上爬取素材需要安装哪些库

想要从网上爬取素材,你需要安装以下库:

1. requests:用于发送HTTP请求并获取网页内容。

```

pip install requests

```

2. BeautifulSoup:用于解析HTML数据,并提取所需的信息。

```

pip install beautifulsoup4

```

3. lxml:用于解析XML和HTML数据。

```

pip install lxml

```

4. selenium:用于模拟浏览器行为,处理JavaScript动态渲染的网页。

```

pip install selenium

```

5. Scrapy:用于构建爬虫框架,实现高效的网页抓取。

```

pip install scrapy

```

这些是一些常用的库,但根据具体需求,可能还需要其他库进行相关的处理和操作。

Python想从网上爬取素材需要安装的库包括:

1. requests:用于发送HTTP请求,获取网页内容。

2. BeautifulSoup:用于解析HTML或XML文档,提取所需数据。

3. lxml:也是用于解析HTML或XML文档的库,比BeautifulSoup更快速、更节省内存。

4. Scrapy:一个Python爬虫框架,提供了高效、可扩展的方式来爬取网页。

以上四个库是Python爬虫的基础库。其中,requests和BeautifulSoup的组合被广泛应用于小规模的网页数据抓取,而Scrapy则适用于大规模、复杂的网站。

解释原因:

到此,以上就是小编对于python怎么爬取网页内的指定内容的问题就介绍到这了,希望介绍的3点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏